Halluzinationen, Prompt-Injections & Co. – LLMs sicher in die Schranken weisen

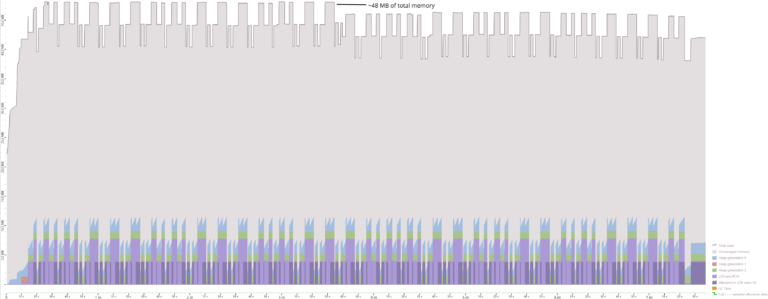

Ein Chatbot halluziniert einem Kunden eine sehr großzügige Erstattungsrichtline herbei und ein Richter entscheidet, dass diese KI-Erfindung für die Firma bindend ist. Ein Benutzer "überredet" ein LLM, alles tun zu können, und erhält prompt Zugriff auf sensible Daten. Beides sind Albtraumszenarien für ein Unternehmen. Aber dennoch: Mit dem großen Erfolg von Chatbots und LLM-Apps erhält die Integration von Generative AI in Businessanwendungen heute eine zentrale Rolle in der Geschäftsstrategie vieler Unternehmen. In dieser Session beleuchtet Sebastian Gingter, wie wir robuste LLM-basierte Lösungen entwickeln können, die sowohl innovativ als auch sicher sind. Wir diskutieren reale Beispiele von Problemen in Anwendungen, die direkt durch ein LLM entstehen, wie eben Halluzinationen oder Prompt-Injection-Angriffe. Sie sehen, welche Maßnahmen führende Anbieter ergriffen haben, um solche Risiken zu verhindern und welche konkreten Möglichkeiten Sie haben, Generative AI in ihre Schranken zu verweisen und zu einem sicheren, vertrauenswürdigen und wertschöpfenden Bestandteil Ihrer Produkte zu machen.

Event

Slidedeck

Weitere Artikel zu aktuellen Schwerpunkten

View Transition API Integration in Angular—a brave new world (Part 1)

AI-Funktionen zu Angular-Apps hinzufügen: lokal und offlinefähig

Data Access in .NET Native AOT with Sessions

Native AOT with ASP.NET Core – Overview